Les opinions exprimées dans cet article sont celles d’un contributeur externe. NotreContinent.com est une plateforme qui encourage la libre expression, la diversité des opinions et les débats respectueux, conformément à notre charte éditoriale « Sur NotreContinent.com chacun est invité à publier ses idées »

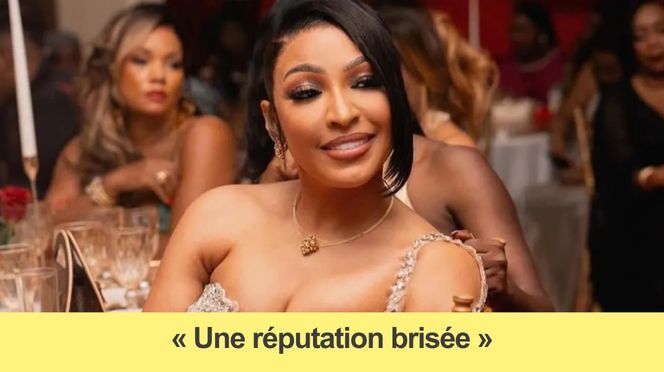

La chanteuse Viviane Chidid a déposé récemment une plainte contre X auprès de la Division spéciale de cybersécurité à Dakar, après la diffusion sur TikTok d’une vidéo la montrant prétendument hospitalisée et d’une voix attribuée à elle évoquant la maladie d’un animateur de télévision. L’affaire intervient alors que la Brigade de Recherches de la Compagnie de Keur Massar a arrêté douze personnes présumées homosexuelles dans la même période, suscitant une forte attention publique au Sénégal. La plainte vise la manipulation numérique et l’usage d’intelligence artificielle pour fabriquer le contenu incriminé.

Le cas frappe par sa brutalité: une image d’un lit d’hôpital, une voix reconstituée, une affirmation simple « Viviane est dans le coma » qui se propage en quelques heures et délite la réputation d’une artiste. Ce n’est pas un simple hoax: c’est une preuve que les outils de production de faux média ont atteint une viralité qui dépasse les garde-fous actuels.

La diffusion de vidéos truquées sur des plateformes grand public n’est pas isolée, et les réseaux sociaux représentent désormais un canal central pour la désinformation qui touche des personnalités comme des citoyens ordinaires.

La mécanique de cette affaire illustre plusieurs défaillances tangibles. D’abord, la facilité de création de contenu deepfake: des logiciels accessibles permettent de synthétiser voix et images sans compétences techniques avancées, rendant la fabrication d’un faux presque industrielle. Ensuite, la chaîne de diffusion: TikTok favorise les formats courts et l’algorithme promeut le contenu susceptible de retenir l’attention, sans exiger de vérification préalable de l’authenticité. Enfin, l’absence de réaction automatisée ou humaine efficace: la vidéo en question a circulé suffisamment longtemps pour générer une plainte officielle avant d’être, le cas échéant, retirée.

Des données publiques montrent que les signalements massifs ne suffisent pas toujours à supprimer rapidement un faux. Sur d’autres plateformes, des études ont recensé des délais de plusieurs heures à plusieurs jours entre la détection et la suppression effective, délai pendant lequel la désinformation s’enracine. La rapidité est d’autant plus critique que la manipulation touche la réputation et la sécurité personnelle d’individus. Comparé à la diffusion traditionnelle de rumeurs dans un quartier, la viralité numérique multiplie l’audience en quelques clics; comparé à la presse écrite qui dispose de procédures de recoupement, la plateforme sociale offre peu de barrières en amont.

La responsabilité des plateformes doit être posée: leur modèle économique récompense l’engagement, pas la véracité. Les outils de modération automatique peinent à distinguer un montage audio sophistiqué d’un enregistrement authentique, surtout quand la vidéo est courte et légère en métadonnées. Les mécanismes de recours actuels paraissent réactifs et opaques: l’utilisateur signale, l’algorithme évalue, puis la décision tombe sans transparence sur les critères appliqués. Les états et les autorités judiciaires s’efforcent d’adapter les cadres légaux, mais la technologie avance plus vite que les normes et que les capacités humaines de contrôle.

Des solutions techniques existent et sont utilisées dans certains contextes: filigranes cryptographiques pour contenus créés par IA, certification des contenus officiels, outils d’authentification des identités. Pourtant, l’adoption généralisée de ces garde-fous reste limitée, en partie pour des raisons de coût, en partie pour des raisons de culture d’entreprise. La comparaison avec les secteurs régulés montre un contraste: dans la finance, la conformité impose traçabilité et auditabilité; sur les plateformes sociales, l’architecture privilégie l’éphémère.

Des rapports internationaux ont documenté la montée des deepfakes depuis 2018 et noté une accélération avec les modèles de synthèse vocale de quatrième génération. Les organismes de cybersécurité recommandent l’intégration de chaînes d’authentification et l’amélioration des outils de détection basée sur l’analyse des artefacts numériques. Les recours judiciaires restent possibles, mais ils sont lents et rarement adaptés à la rapidité virale d’une plateforme comme TikTok.

L’affaire Viviane Chidid met en lumière une fragilité majeure: les plateformes sociales peuvent propager des faux crédibles en quelques instants, sans mécanismes robustes pour stopper la désinformation nuisible. Les faits montrent une chaîne défaillante entre création, diffusion et vérification, et indiquent que responsabilité algorithmique, transparence des procédures et outils d’authentification sont des éléments factuels à renforcer si l’on veut empêcher que la réputation et la sécurité des personnes deviennent les premières victimes d’un numérique non régulé.

Article opinion écrit par la créatrice de contenu : Oumou Khairy.

Mis en ligne : 14/02/2026

—

La plateforme NOTRECONTINENT.COM permet à tous de diffuser gratuitement et librement les informations et opinions provenant des citoyens. Les particuliers, associations, ONG ou professionnels peuvent créer un compte et publier leurs articles Cliquez-ici.